みなさんこんにちは。テックブログも3回目ですね。

MyDearestでエンジニアしてます大川と申します。

あ?お前誰だよ?何してンだよ?

様式になってしまった見出し...もとい自己紹介です。

東京クロノスではキャラクター組み込み回りの開発を担当しています。

簡単に説明すると、モデラーやアニメーターが作成した3Dのキャラクターモデルやモーションデータをゲーム中で使えるように実装することが仕事です。

あとは、Yuria's MiscNote(ユリアのミスクノート)の動画も作らせてもらっています(ご覧になった方いらっしゃいますかね?)

今回はキャラクターの実装回りの話...ではなく、

上に載せてある動画の作成を具体的な事例としたゲーム外部でのあれこれについてお話したいと思います。(キャラクターの実装回りはまた後日!)

・

・

・

■□Yuria's MiscNote について□■

Yuria's MiscNoteは東京ゲームショウ2018で東京クロノスがデモ出展しているさなか、こっそりと公開された動画です(実はこっそりすぎて公式がこの動画について触れるのは初めてだったりします)

東国ユリアがどんな子なのかを垣間見ることのできる内容になっています。

この動画、素材の撮影は全てUnity上で行っており、最後の編集のみAdobe AfterEffectを使用して作成された準Unity製動画です。では、こちらをどのように作っていったかをみていきましょう。

■□キャラクターの動きについて□■

動画中のキャラクターの動きは全て"OculusRift" と"OculusTouch" を実際に人が身に着けて動いたものを使用しています。

音声に合わせて、頭と両手の先の動きを収録して、大枠の動きを準備してから、細かい動きを追加してキャラクターの動きを作っています。

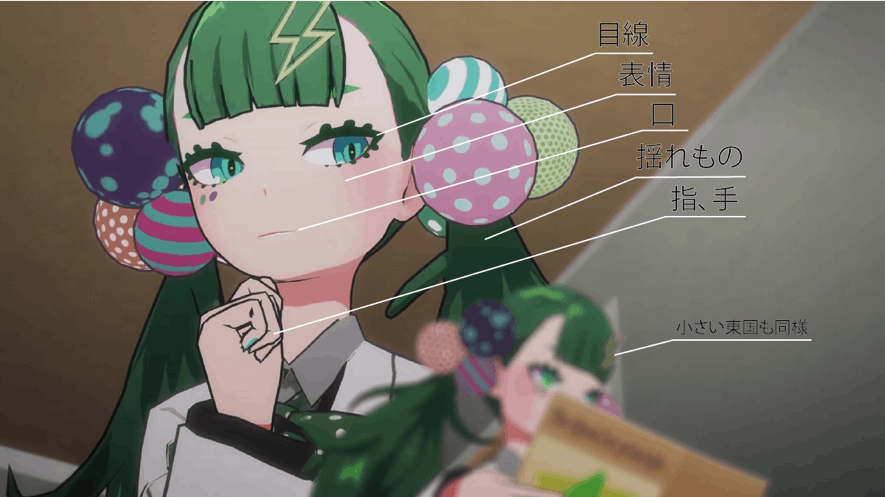

画像のように細かく動きを作らなければいけないところはたくさんありますが、自動化できるところはいくつかのアセット(便利機能のようなもの)を使用して動きを作っています。

1. 頭と手の先以外の部分

- "FinalIK" を用いて制御しており、肘や胴体などの直接動きを収録していない部分の動きが自然にできるようにしています。

2. 服や髪の毛の揺れ

- "DynamicBone"というアセットと使用していて、動きに合わせていい感じに揺れてくれるようにしています。

3. 音声に合わせた口の動き

- "OVRLipSync"を使って波形情報にあわせた口の形が作られるようにしています。

なにやらたくさんのアセット使っているようですが、VR界隈では広く知られているアセット達です。実はこれらを使えばリアルタイムでVTuberのようなこともできてしまいます。東国がVTuberとなる日が来るのかはわかりませんが...。

■□モーションの撮影について□■

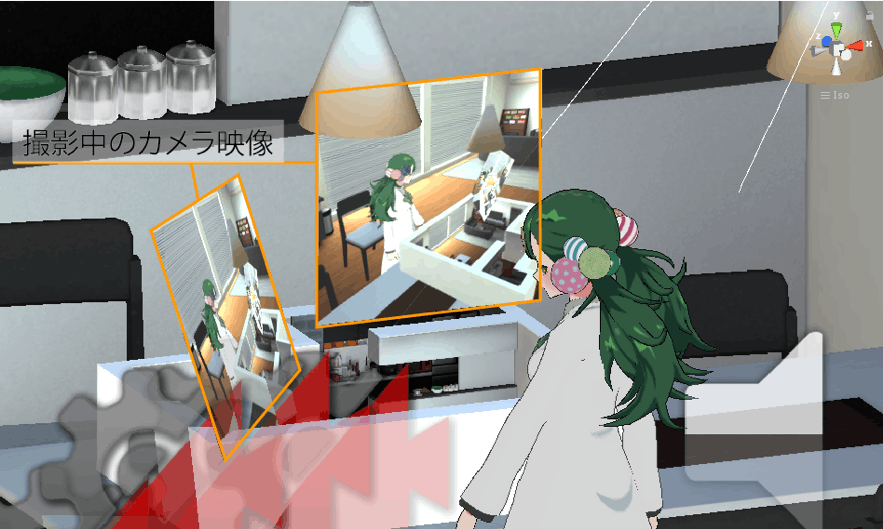

演技するときに演者にはVRを通して実際にキャラになりきって動作をしてもらいました。

今回は"OculusRift"を被るとそのまま、東国の家のリビングにいる状態で収録を行っています。

東国の家で東国になりきって動いてもらう...。

そんな状態での撮影です。家の中には顔を向けてほしい方向に本番と同じ位置のカメラから映っている映像が見えるように、空間にモニターのような板を複数配置していました。

これでどのように映っているのか確認しながら必要な演技をすることが出来るようにしていました。

なかなか現実のドラマ撮影ではありえないような光景な気がしますね。

■□Adobe AfterEffectを使用した編集について□■

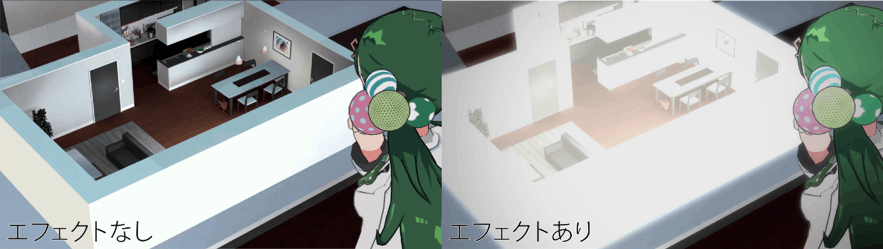

キャラクターの動きやカメラの動きが出来上がった後はレイヤーに分けて撮影を行いました。背景や、キャラクターは別々に出力してそれぞれに効果を追加してから合成しています。

小さい東国が出てくるときのエフェクトや色調整、コマ落としetc...。最後に演出を加えることで見た目がガラッと変わります。

この編集作業はアニメの作り方に近い方法です。

・

・

・

というような感じで、ここまでがYuria's MiscNoteの作り方でした。

そういえば、先日公開された第2弾PVご覧になりました?

藍井エイルさんの新曲ほんとにかっこいいですよね。

このPVの中にもゲーム本編からいくつかシーンを持ってきています。

VRコンテンツの共通の悩みとして、体験している映像をそのまま宣伝に使用しようとすると、全然魅力が伝わらないといったことが多々あります。

人がHMDをかぶって見えている映像を撮影すると、細かい揺れが発生したり、よさそうに撮影できたと思っても、両目で見ていることもあって、どちらかの目から見えている状態に寄ってしまって中心がずれてしまったりということがあったりします。

使用されなかったスクショを乗っけておく...

短いカットで使用する映像でしたが、上記のこともあったので、PVの撮影にはヘッドマウントディスプレイ(HMD)が繋がっていないPCを用意して、開発版のデータを使用して撮影を行いました(※発売後の本編はHMDを外して遊べるわけではありません。)

カメラの動きはアニメーションデータとして保存しておき、日本語版、英語版で同じシーンを撮影しています。

手振れも発生せず、平面で見える様子を確認できる状態で撮影することができました。

VRを使用した動画制作は、いまだこれが一番良いという方法はありません。

人によっても全く違うアプローチがとれる面白い分野かなと思います。

今回はゲーム外の場所で使われている技術的な内容についてVRが出てき始めたこの時期だからこそ取り上げてもよい内容かと思い紹介させていただきました。

使えそうなところにVRを取り入れ、かつVRだからこそできることをしてみることで今までできなかった表現ができるようにならないかと試行錯誤の毎日です。

...書き終わったので、開発戻ってもいいでしょうか?ぼっちPさん。